| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- git push

- github

- local repository 생성

- python

- STAGE

- remote repository 생성

- 수정사항업데이트

- git

- GitHub 설치

- git commit

- Restore

- 1

- Push

- git config global

- 정규식

- 백준

- 1330

- 15596

- amend

- Baekjoon

- commit

- 파이썬

- 두수비교하기

- 함수

- boostcamp #aI tech #주간리뷰

- regExr

- ADD

- Reset

- Today

- Total

Très bien

Graph Neural Network 본문

★★★ KAIST 신기정 교수님의 GNN 강의 및 강의 자료를 학습한 내용입니다. ★★★

1. Transductive vs. Inductive

Transductive Method (변환식 방법) : 학습의 결과로 node embedding 자체를 획득함.

Inductive Method (귀납적 방법) : 학습의 결과로 node를 embedding으로 변환시키는 함수, Encoder를 획득함.

2. GNN(Graph Neural Network)

Graph를 각 노드에 대해 Layer 들의 집합으로 표현할 수 있습니다. 하나의 Layer에 속하는 함수들은 모두 동일하며, 이웃 노드들의 정보를 수집하여 노드 연산이 수행될 수 있습니다. 특히, 동일 Layer에 속하는 다수 개의 함수들은 그 입력값의 개수가 모두 상이하지만, 평균 등의 함수를 적용하여 이웃하는 노드(입력 노드)의 개수와 상관없이 동일한 함수가 연산됩니다. 대상 노드별로 연산이 진행되는 구조를 Computation Graph 라고 부릅니다.

기본적인 GNN의 노드 연산식은 정리하면 다음 그림과 같이 정리할 수 있으며, Neural Network을 통해 학습하는 가중치 파라미터는 W와 B입니다.

3. Graph Attential Network (GAN)

그래프를 학습시킬 때, edge의 가중치도 학습을 합니다. 왜냐하면, 각 이웃 노드별로 미치는 영향이 다를 수 있기 때문입니다. 각 층에서 node i로부터 이웃 노드, j의 가중치는 세 단계를 통해 계산할 수 있습니다.

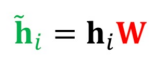

- 해당 층의 node i의 임베딩 hi에 신경망 W를 곱해 새로운 임베딩을 얻습니다.

- node i와 node j의 새로운 임베딩을 연결한 후, 어텐션 계수 a를 내적합니다. 어텐션 계수는 모든 정점이 공유하는 학습 변수 입니다.

- 결과에 소프트맥스를 적용합니다.

'Study > Deep Learning' 카테고리의 다른 글

| Papers with Code (0) | 2022.02.25 |

|---|---|

| Deep Learning - Intro. (0) | 2022.02.07 |